Multisite Robots.txt Manager

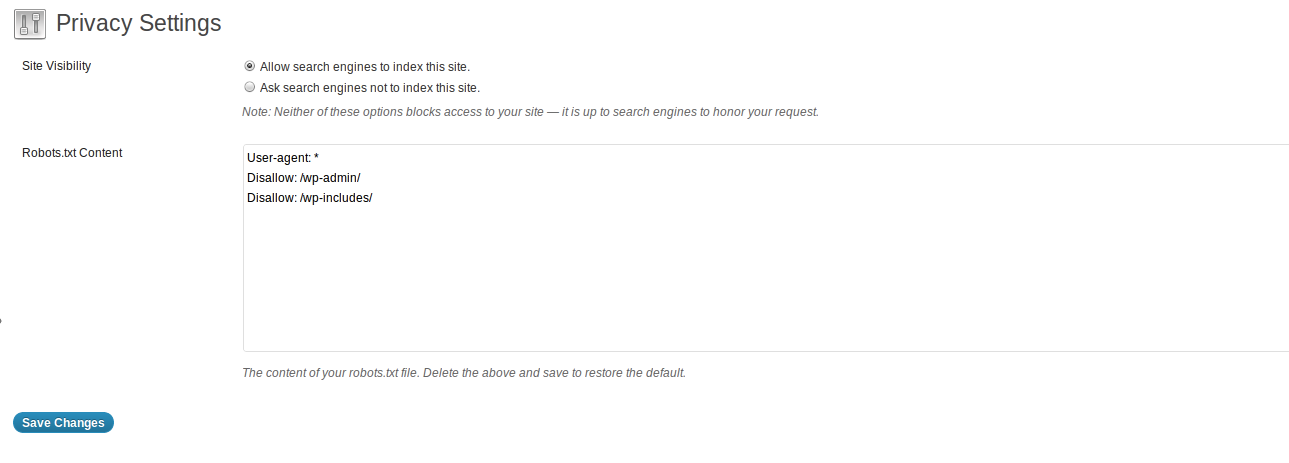

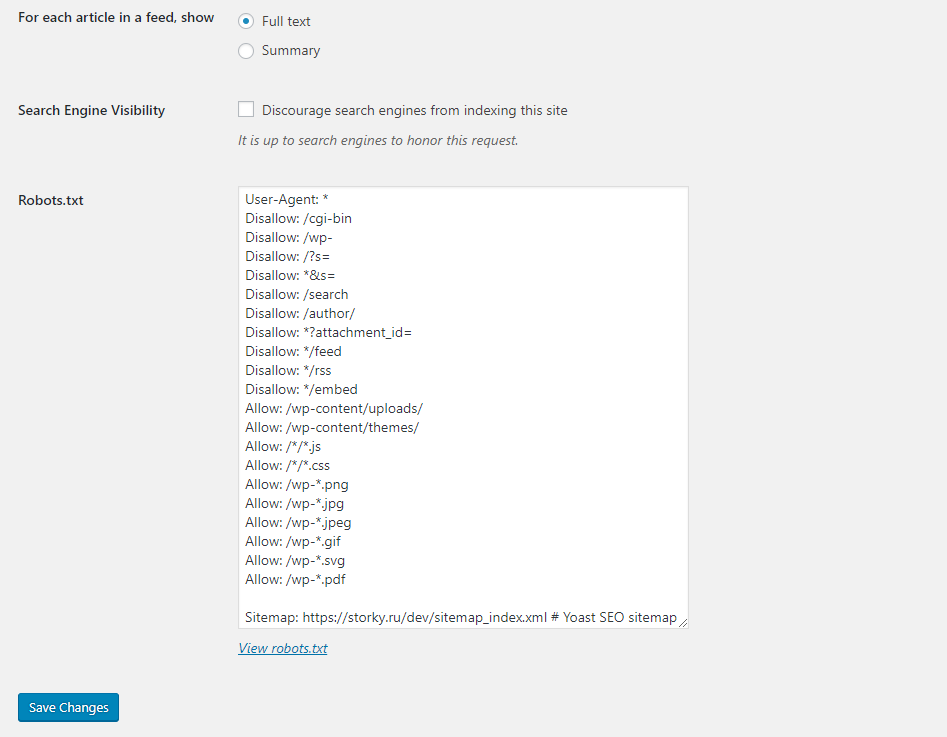

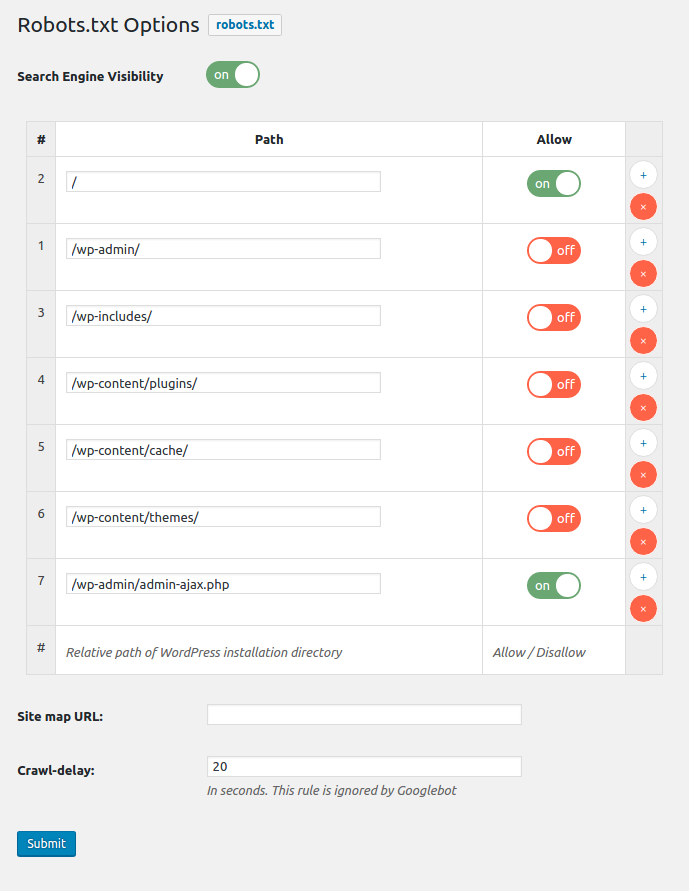

Плагин менеджера Robots.txt для многосайтовых сетей WordPress. Быстро и легко управляйте всеми файлами robots.txt в многосайтовой сети веб-сайтов WordPress. !!! Только для мультисайтовых установок с поддержкой сети !!! Этот плагин был создан для многосайтовых сетей> Только для сетевой активации! Для поддержки и ошибок, пожалуйста, свяжитесь с нами напрямую, если вам нужна помощь или вы обнаружили ошибку. Форум поддержки WordPress не уведомляет нас о новых обращениях в службу поддержки, не знаю почему, поэтому свяжитесь с нами напрямую. Просматривайте, сообщайте об ошибках, вносите свой вклад! Посетите этот плагин на Github! Клонируйте / разветвите себе копию, сообщите об ошибке или отправьте заявку и запрос на включение! Особенности: Сетевой файл robots.txt, общий для всех сайтов. Добавьте дополнительные данные файла robots.txt для каждого веб-сайта администратора. Создавайте уникальные файлы robots.txt для каждого сетевого веб-сайта. Управляйте всеми веб-сайтами из области сетевого администрирования. Управляйте одним веб-сайтом через администраторов настроек веб-сайта. Автоматически сгенерированные URL-адреса карты сайта, путь загрузки и путь к теме. Массовое обновление всех веб-сайтов в сети в один клик. Быстро публикуйте файлы настроек robots.txt в сети. Сканируйте и очищайте старые данные плагина файла robots.txt, чтобы устранить конфликты. Краткая информация. Файл robots.txt, используемый по умолчанию для всей сети, НЕ является действующим файлом robots.txt. Если вы деактивируете плагин, никакие параметры не будут удалены, но файлы плагинов robots.txt больше не будут отображаться. Если вы удалите этот плагин, все параметры и настройки будут удалены из базы данных для всех веб-сайтов. Получите подключаемый модуль: Загрузить> Установить> Сеть Активировать доступ к сети: Администратор сети> Вкладка «Настройки»> Ссылка на MS Robots.txt Доступ к веб-сайту: Администратор веб-сайта> Вкладка «Настройки»> Ссылка MS Robots.txt «Сделайте это»: Администратор сети: выберите либо с помощью « Опубликовать сетевой файл robots.txt на всех сетевых веб-сайтах »или« Опубликовать сетевой файл robots.txt на сетевых веб-сайтах, участником которых вы являетесь », затем нажмите кнопку« Обновить настройки », чтобы опубликовать файлы robots.txt. Администратор веб-сайта: измените добавленный файл robots.txt (или создайте уникальный файл robots.txt для веб-сайта), затем нажмите кнопку «обновить правила веб-сайта», чтобы опубликовать свои изменения. Произвольный раздел Общие сведения о настройках по умолчанию Когда вы впервые входите в админку плагина через администратора сети, отображаемый файл robots.txt является копией по умолчанию «только для сети». Маркер добавления к сети Маркер {APPEND_WEBSITE_ROBOTSTXT} в файле Network Robots.txt заменяется правилами добавления уникального файла robots.txt веб-сайта. Используйте маркер в настраиваемых файлах robots.txt сети, чтобы автоматически добавлять правила файла robots.txt веб-сайта при обновлении сети. Файлы robots.txt в каталогах Этот плагин БУДЕТ отображать файлы robots.txt в каталогах, однако поисковые пауки читают только файлы robots.txt, находящиеся в корневом каталоге веб-сайта. Пауки не читают файлы robots.txt в каталогах, например: domain.com/PATH-or-FOLDER/robots.txt НЕ является допустимым местоположением. От Google: «Файл robots.txt должен находиться в каталоге верхнего уровня хоста… .. Сканеры не будут проверять файлы robots.txt в подкаталогах». Тестирование файлов Robots.txt Используйте инструменты Google для веб-мастеров, чтобы проверить файлы Robots.txt…. по крайней мере с Google: войдите в свою учетную запись Google и получите доступ к функции входа в Инструменты для веб-мастеров. Выберите веб-сайт или добавьте веб-сайт…. На главной странице Инструментов для веб-мастеров щелкните нужный сайт. В разделе «Работоспособность» нажмите «Заблокированные URL-адреса». Если он еще не выбран, перейдите на вкладку Test robots.txt. Скопируйте содержимое файла robots.txt и вставьте его в первое поле. В поле URL-адреса укажите сайт для проверки. В списке «Пользовательские агенты» выберите нужные пользовательские агенты. https://developers.google.com/webmasters/control-crawl-index/docs/robots_txt Новый веб-сайт, добавленный в сеть Если все веб-сайты используют сохраненный сетевой файл robots.txt по умолчанию, нажмите кнопку «Обновить настройки», чтобы скопировать значение по умолчанию. robots.txt на любые новые веб-сайты, которые у вас есть. Для каждого сайта: затем нажмите кнопку «Обновить правила веб-сайта», чтобы скопировать файл robots.txt по умолчанию на этот веб-сайт. Отключение отключения веб-сайта: в админке плагина веб-сайта для каждого уникального веб-сайта прокрутите вниз и установите флажок «Отключить сохраненный файл robots.txt…», затем нажмите кнопку отправки. Это отключит файл robots.txt только для веб-сайта, и отобразится файл robots.txt по умолчанию WordPress. Отключить через сеть: в администраторе сетевого плагина прокрутите вниз и установите флажок «Отключить сохраненные файлы robots.txt…», затем нажмите кнопку отправки. = Предустановки Эта функция позволяет быстро копировать готовые файлы robots.txt и URL-адрес структуры карты сайта в сетевой файл robots.txt по умолчанию. Это действие не публикует файлы robots.txt в сети. Рекомендуемые подключаемые модули Sitemap Google XML Sitemaps: https://wordpress.org/extend/plugins/google-sitemap-generator/ Улучшенные файлы Sitemap Google XML для WordPress: https://wordpress.org/extend/plugins/bwp-google-xml-sitemaps / Поиск других: https://wordpress.org/extend/plugins/search.php?q=multisite+sitemap Для «настоящих» многоузловых HOST-сетей используйте плагин WordPress: BWP Google XML Sitemaps - этот плагин перечислит все веб-сайты. URL-адреса карты сайта в файле robots.txt веб-сайта корневой сети.

Автор: tribalNerd, Chris Winters

Версия: 3.0.0

Последнее обновление: 2020-04-12 12:11am GMT