WordPress Robots.txt optimization (+ XML Sitemap) – Website traffic, SEO & ranking Booster

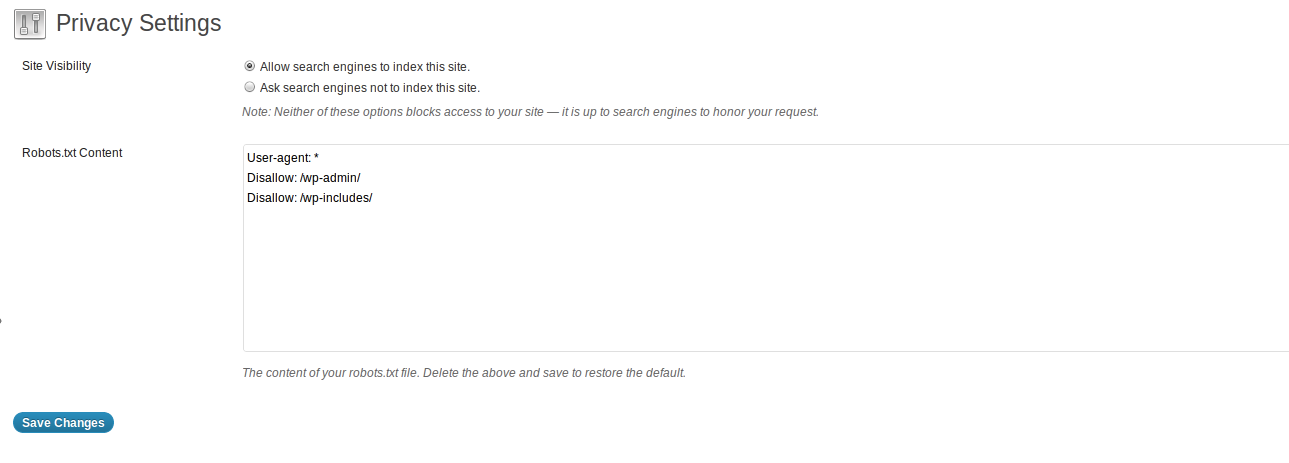

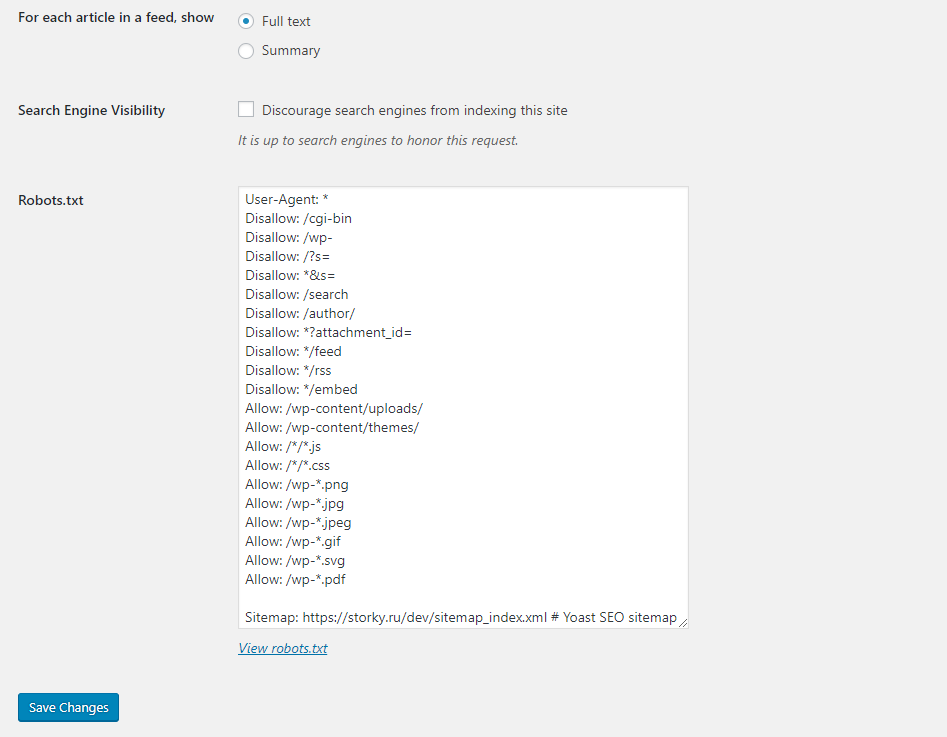

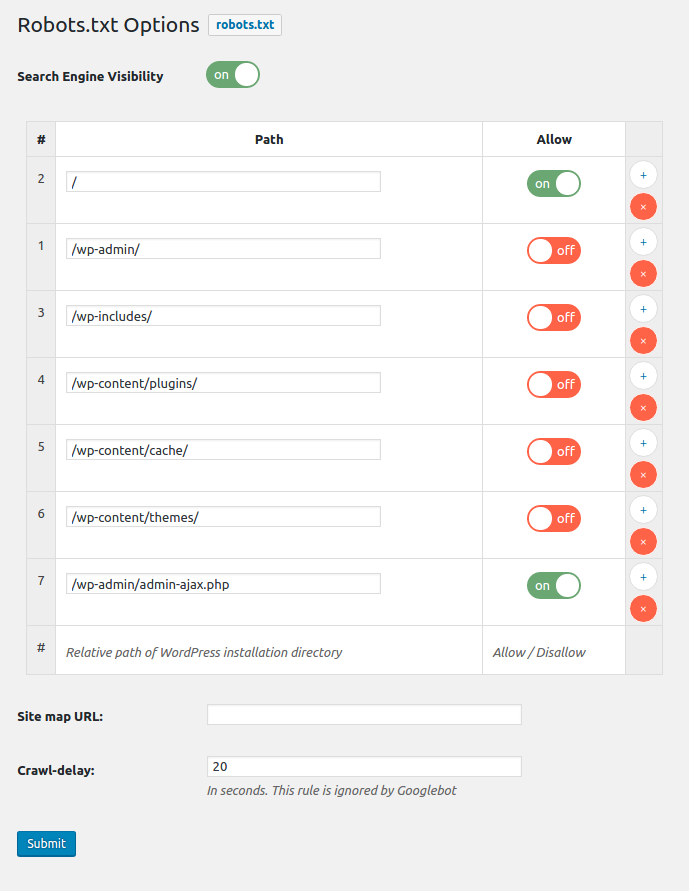

Better Robots.txt создает виртуальный файл robots.txt WordPress, помогает вам повысить SEO вашего сайта (возможности индексации, рейтинг Google и т. Д.) И производительность загрузки - Совместимость с Yoast SEO, Google Merchant, WooCommerce и сетевыми сайтами на основе каталогов (MULTISITE) С помощью Better Robots.txt вы можете определить, каким поисковым системам разрешено сканировать ваш веб-сайт (или нет), указать четкие инструкции о том, что им разрешено (или нет), и определить задержку сканирования (для защиты вашего хостинг-сервера от агрессивных действий). скребки). Better Robots.txt также дает вам полный контроль над содержимым файла robots.txt WordPress с помощью окна пользовательских настроек. Уменьшите экологический след вашего сайта и производство парниковых газов (CO2), обусловленное его существованием в Интернете. Краткий обзор: ПОДДЕРЖИВАЕТСЯ НА 7 ЯЗЫКАХ Плагины Better Robots.txt переведены и доступны на следующих языках: китайский - 汉语 / 漢語, английский, французский - французский, русский –Руссɤɢɣ, португальский - Português, испанский - Español, немецкий - немецкий Знаете ли вы, что … Файл robots.txt - это простой текстовый файл, размещаемый на вашем веб-сервере, который сообщает поисковым роботам (например, роботу Google), следует ли им обращаться к файлу. Файл robots.txt контролирует, как пауки поисковых систем видят ваши веб-страницы и взаимодействуют с ними; Этот файл и боты, с которыми они взаимодействуют, являются фундаментальными частями работы поисковых систем; Первое, на что смотрит сканер поисковой системы при посещении страницы, - это файл robots.txt; Robots.txt - это источник сока SEO, который только и ждет, чтобы его разблокировали. Попробуйте Better Robots.txt! О версии Pro (дополнительные функции): 1. Повысьте свой контент в поисковых системах с помощью карты сайта! Убедитесь, что ваши страницы, статьи и продукты, даже самые последние, принимаются во внимание поисковыми системами! Плагин Better Robots.txt был создан для работы с плагином Yoast SEO (вероятно, лучшим плагином SEO для веб-сайтов WordPress). Он определит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, то он автоматически добавит инструкции в файл Robots.txt, предлагая ботам / сканерам прочитать вашу карту сайта и проверить, внесли ли вы последние изменения на свой сайт (чтобы поисковые системы могли сканировать новый доступный контент). Если вы хотите добавить свою собственную карту сайта (или если вы используете другой плагин SEO), вам просто нужно скопировать и вставить URL-адрес вашей карты сайта, и Better Robots.txt добавит его в ваш WordPress Robots.txt. 2. Защитите свои данные и контент. Не позволяйте вредоносным ботам сканировать ваш веб-сайт и коммерциализировать ваши данные. Плагин Better Robots.txt помогает заблокировать сканирование и очистку ваших данных наиболее популярными вредоносными ботами. Когда дело доходит до сканирования вашего сайта, есть хорошие и плохие боты. Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие сканируют ваш сайт по более гнусным причинам, таким как удаление вашего контента (текста, цены и т. Д.) Для повторной публикации, загрузки целых архивов вашего сайта или извлечения ваших изображений. Сообщалось, что некоторые боты даже закрывали целые веб-сайты в результате интенсивного использования широкополосного доступа. Плагин Better Robots.txt защищает ваш веб-сайт от пауков / парсеров, определенных Distil Networks как плохих ботов. 3. Скрывайте и защищайте свои обратные ссылки. Не позволяйте конкурентам определять ваши прибыльные обратные ссылки. Обратные ссылки, также называемые «входящими ссылками» или «входящими ссылками», создаются, когда один веб-сайт ссылается на другой. Ссылка на внешний веб-сайт называется обратной ссылкой. Обратные ссылки особенно ценны для SEO, потому что они представляют собой «вотум доверия» от одного сайта к другому. По сути, обратные ссылки на ваш сайт являются сигналом для поисковых систем о том, что другие ручаются за ваш контент. Если многие сайты ссылаются на одну и ту же веб-страницу или веб-сайт, поисковые системы могут сделать вывод, что на контент стоит ссылаться и, следовательно, также стоит показывать его в поисковой выдаче. Таким образом, получение этих обратных ссылок оказывает положительное влияние на позицию сайта в рейтинге или видимость в поиске. В индустрии SEM специалисты очень часто определяют, откуда берутся эти обратные ссылки (от конкурентов), чтобы отсортировать лучшие из них и генерировать высококачественные обратные ссылки для своих клиентов. Учитывая, что создание очень прибыльных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам так легко идентифицировать и дублировать их, это чистая потеря эффективности. Better Robots.txt поможет вам заблокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки не обнаруживались. 4. Избегайте спамерских обратных ссылок. Боты заполняют формы комментариев на вашем веб-сайте, говоря вам «отличная статья», «любите информацию», «надеюсь, что вы сможете подробнее рассказать о теме в ближайшее время» или даже предоставляя персонализированные комментарии, включая имя автора. Спам-боты со временем становятся все более умными, и, к сожалению, ссылки для спама в комментариях могут действительно повредить вашему профилю обратных ссылок. Better Robots.txt поможет вам избежать индексации этих комментариев поисковыми системами. 5. Инструменты SEO При улучшении нашего плагина мы добавили ссылки на 2 очень важных инструмента (если вас беспокоит ваш рейтинг в поисковых системах): Google Search Console и Bing Webmaster Tool. Если вы еще не используете их, теперь вы можете управлять индексированием своего веб-сайта, оптимизируя файл robots.txt! Также был добавлен прямой доступ к инструменту массового пинга, который позволяет пинговать свои ссылки в более чем 70 поисковых системах. Мы также создали 4 ярлыка, относящиеся к лучшим онлайн-инструментам SEO, непосредственно доступным на Better Robots.txt SEO PRO. Так что теперь вы можете в любое время проверить производительность загрузки вашего сайта, проанализировать свой SEO-рейтинг, определить свой текущий рейтинг в поисковой выдаче с помощью ключевых слов и трафика и даже просканировать весь сайт на наличие мертвых ссылок (ошибки 404, 503, …) Прямо из плагина. 6. Будьте уникальны. Мы подумали, что можем добавить нотку оригинальности в Better Robots.txt, добавив функцию, позволяющую «настраивать» ваш файл robots.txt WordPress с помощью собственной уникальной «подписи». Большинство крупных компаний в мире персонализировали свой robots.txt, добавив пословицы (https://www.yelp.com/robots.txt), слоганы (https://www.youtube.com/robots.txt) или даже рисунки. (https://store.nike.com/robots.txt - внизу). А почему не ты тоже? Вот почему мы выделили специальную область на странице настроек, где вы можете писать или рисовать все, что хотите (действительно), не влияя на эффективность robots.txt. 7. Предотвратить сканирование роботами бесполезных ссылок WooCommerce Мы добавили уникальную функцию, позволяющую блокировать сканирование определенных ссылок («добавить в корзину», «заказать», «заполнить», корзину, учетную запись, оформить заказ и т. Д.) Поисковыми системами. Большинство этих ссылок требуют значительного использования ЦП, памяти и полосы пропускания (на хост-сервере), потому что они не кэшируются и / или создают «бесконечные» циклы сканирования (пока они бесполезны). Оптимизация вашего файла robots.txt в WordPress для WooCommerce при наличии интернет-магазина позволяет обеспечить большую вычислительную мощность для действительно важных страниц и повысить производительность загрузки. 8. Избегайте ловушек поисковых роботов. «Ловушки поисковых роботов» - это структурная проблема на веб-сайте, которая заставляет сканеры находить практически бесконечное количество нерелевантных URL. Теоретически сканеры могут застрять в одной части веб-сайта и никогда не завершить сканирование этих нерелевантных URL-адресов. Улучшенный файл Robots.txt помогает предотвратить ловушки сканера, которые сокращают бюджет сканирования и вызывают дублирование контента. 9. Инструменты для взлома роста. Сегодня самые быстрорастущие компании, такие как Amazon, Airbnb и Facebook, способствовали прорывному росту, объединив свои команды вокруг высокоскоростного процесса тестирования / обучения. Речь идет о взломе роста. Взлом роста - это процесс быстрого экспериментирования и реализации маркетинговых и рекламных стратегий, которые ориентированы исключительно на эффективный и быстрый рост бизнеса. Better Robots.txt предоставляет список из 150+ инструментов, доступных в Интернете, чтобы ускорить ваш рост. 10. Мета-поле сообщения Robots.txt для ручных исключений Этот мета-поле сообщения позволяет установить «вручную», должна ли страница быть видимой (или нет) в поисковых системах, путем внедрения специального правила «запретить» + «noindex» внутри ваших роботов WordPress. .текст. Почему это полезно для вашего рейтинга в поисковых системах? Просто потому, что некоторые страницы не предназначены для сканирования / индексации. Страницы с благодарностью, целевые страницы, страницы, содержащие исключительно формы, полезны для посетителей, но не для поисковых роботов, и вам не нужно, чтобы они были видны в поисковых системах. Кроме того, некоторые страницы, содержащие динамические календари (для онлайн-бронирования) НИКОГДА не должны быть доступны для поисковых роботов, поскольку они имеют тенденцию заманивать их в бесконечные циклы сканирования, что напрямую влияет на ваш бюджет сканирования (и ваш рейтинг). 11. Возможность сканирования Ads.txt и App-ads.txt Чтобы обеспечить сканирование ads.txt и app-ads.txt поисковыми системами, плагин Better Robots.txt проверяет, что они по умолчанию разрешены в файле Robots.txt. независимо от вашей конфигурации. Для вашего сведения, авторизованные цифровые продавцы для Интернета или ads.txt - это инициатива IAB, направленная на повышение прозрачности программной рекламы. Вы можете создать свои собственные файлы ads.txt, чтобы определить, кто имеет право продавать ваши ресурсы. Файлы являются общедоступными и могут сканироваться биржами, платформами поставщиков (SSP) и другими покупателями и сторонними поставщиками. Авторизованные продавцы для приложений или app-ads.txt - это расширение стандарта авторизованных цифровых продавцов. Он расширяет совместимость для поддержки рекламы, отображаемой в мобильных приложениях. Как всегда, впереди еще кое-что…

Автор: Pagup

Версия: 1.4.1.1